TEC crea primer capítulo estudiantil centroamericano de calidad

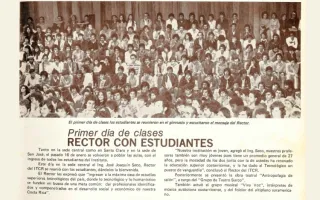

Así fue la bienvenida estudiantil en 1978

Primera graduada: “Estamos viendo los frutos del TEC en Limón”

La herencia de “Rafles” al TEC

Estamos a un click de la noticia

La Oficina de Comunicación y Mercadeo no toma como suyas, las opiniones vertidas en esta sección.

_______________________________________________________________________________________________

Hace casi dos semanas, la Comunidad Institucional ha tenido la oportunidad de visualizar el remozamiento del medio de comunicación institucional Hoy en el TEC, acorde con las últimas tendencias de la comunicación digital.

Verano Infantil: en escena con dos obras de teatro

TEC apoya a cooperativas en la diversificación de sus productos

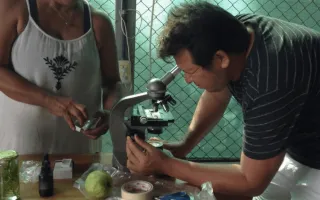

Desde inicios del 2016, el Tecnológico de Costa Rica (TEC) se encuentra realizando con dos cooperativas un trabajo que consiste en la creación de productos a partir de su material de rechazo.

Se trata del proyecto “Fortalecimiento de las capacidades de dos cooperativas costarricenses en el aprovechamiento de sus cultivos mediante el desarrollo de productos agroindustriales”.

Centro Académico de Alajuela cuenta con nuevo director

El pasado 16 de marzo el Dr. Roberto Pereira Arroyo asumió, durante los próximos tres años, la Dirección del Centro Académico Alajuela del Tecnológico de Costa Rica (TEC), ubicado en la Sede Interuniversitaria (SIUA) de esta provincia.

Pereira, quien anterior a esta función se desempeñaba como docente en la Escuela de Ingeniería en Electrónica, detalló una serie de proyectos que espera ejecutar durante su gestión.

¿De qué manera las medidas de Donald Trump podrían afectar a Costa Rica?

La Oficina de Comunicación y Mercadeo no toma como suyas las opiniones vertidas en esta sección.

En esta ocasión, cuatro alumnos de distintas carreras del Tecnológico de Costa Rica (TEC) opinan sobre un tema que está en boca de todo el mundo: las políticas del nuevo gobierno de Donald Trump en Estados Unidos y la influencia que pueden tener sobre el país.